新智元报道

编辑:弗格森 刘小芹

【新智元导读】人机对战第二场,柯洁认输,AlphaGo中盘获胜将比分改写为2:0,TPU可谓是本次AlphaGo升级的秘密武器。 由此,许多人认为,谷歌与英伟达必有一战。谷歌已经开始向中国市场上的企业和开发者兜售自己的TPU,加上TensorFlow和谷歌云等标志性业务。这对在深度学习上获利丰厚的英伟达来说可能并不是一件好事。

柯洁又输了,与AlphaGo的对决比分被改写为0:2 !

AlphaGo变得更强大了,此前DeepMind和谷歌团队在新闻发布会上说,。除了算法上的改进之外,他们也特别强调了谷歌云和 TPU(向量处理单元)等计算资源上的改进对 AlphaGo 的巨大提升作用。“对战柯洁的AlphaGo Master使用更加有效的算法,所需的计算量是AlphaGo的1/10。AlphaGo Master使用谷歌云提供的4块TPU单机,你可以把它当做是一台计算机。” TPU 可谓是“阿老师”背后的秘密武器。

TPU 是谷歌特别设计用于神经网络计算的芯片。 谷歌在年度 Google I / O 大会推出了 TensorFlow Processing Unit(张量处理单元,TPU)的第2代以及 Cloud TPU。一时间引起业界热议。

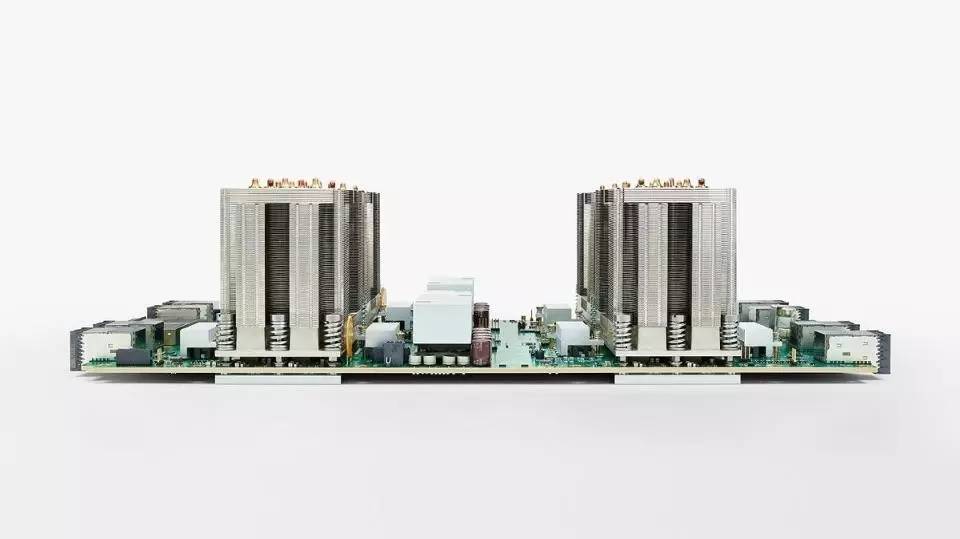

与谷歌的第一代 TPU ASIC (专用集成电路)不同,Cloud TPU 被设计用来支持 AI 的神经网络训练或推理的使用。第二代 TPU 芯片为机器学习提供每秒45万亿次浮点运算(约相当于 16位 TFLOPS),大约是英伟达P100(20 TFLOPS)或AMD即将推出的 Vega GPU(25 TFLOPS)的两倍。不过,它还不够英伟达新推出的 Volta 芯片快。Cloud TPU 封装在一个4芯片的模块上,具有把这些强大的处理器连接起来的结构,可以实现非常高的处理性能。这种 scaling 的功能很重要,因为这样的话可以利用几乎是无限的加速器供应来训练神经网络。

巧合还是针锋相对:谷歌与英伟达必有一战?

TPU 在机器学习中的表现似乎优于英伟达的 Tesla Volta GPU。新版本的TPU发布时,距离英伟达推出 Tesla Volta GPU 还不到一周的时间。

四芯片的 Cloud TPU 能够提供 180 TFLOPS 的浮点运算速度,用 32 个互相连接的板组成一个 “TPU Pod”,峰值性能可达 11.5 petaflops——实际上是单个机架上的一个大型超级计算机。

谷歌还宣布推出 TensorFlow Research Cloud,这是一个包含 1000 TPU (4000 Cloud TPU 芯片)的超级计算机,提供180 PetaFlops(约16位FLOP)的计算能力,将免费提供给合格的研究团队。虽然这与英伟达的 Saturn V 超级计算机的概念相似,但规模更大。此外,谷歌的超级计算机的设计仅支持谷歌自己的开源 TensorFlow 机器学习框架和生态系统,而 Saturn V 可适用于所有类型的软件。

可以看到,相对英伟达的GPU,谷歌有了TPU,相对英伟达的Saturn V 超级计算机,谷歌有了TensorFlow Research Cloud。谷歌似乎在步步紧逼近年来上升势头的英伟达。

显然,因为有大量机器学习的需求,谷歌一直是英伟达GPU的一个非常大的(也许是最大的)客户。当前几乎所有的谷歌和其它人的神经网络训练都是用的英伟达GPU。但英伟达并没有故步自封。就在不久前,英伟达宣布即将推出的基于Volta的Tesla V100 GPU,其中的创新还包括一种新型处理器内核,能够提供高达120TFLOPS的超强运算性能,比单个 Cloud TPU芯片高2.6倍。Tesla V100 非常强大,也因此非常昂贵,它的面积为815 平方毫米,内置210亿个晶体管,比Pascal P100大33%。

事实上,英伟达 CEO黄仁勋在GTC主题演讲中表示,Volta是迄今为止最大,也是最复杂的芯片。但Volta必须做得很大:它不仅仅是一个深度学习 ASIC,它支持用于科学应用的32位和64位浮点数以及大规模超级计算机所需的错误纠正内存。IBM和英伟达赢得了如今三大DOE超级计算机合同中的两个,其中很大一部分是因为Volta芯片。Volta芯片可以说肯定是世界上最快的图形芯片。这些特点正是ASIC能够超越GPU的原因。

所以,谷歌Cloud TPU会对英伟达产生影响,但至少在短期内,由于以上讨论到的限制,影响的量级可能会比您想象的要低。Cloud TPU只能在谷歌和谷歌云的计算引擎内部使用。而且只能在使用TensorFlow的项目中使用,甚至只有在公共云基础设施中运行应用程序的项目才能有安全性、业务和监管方面的意义,因为谷歌对于做给其竞争对手的商业芯片供应商并不感兴趣。英伟达公司的机器学习GPU的占有率为20%,该业务每年增长近3倍(最近一个季度为186%),因此其它方面的增长将有助抵消谷歌这边的损失。

即使TPU被引入到其他机器学习ASIC芯片,也无法抵消Google TPU的自身限制。这就是英伟达自己的“类似TPU的”深度学习加速器(DLA)可能发挥作用的地方。 正如此前文章中所讨论的,英伟达已经宣布将开源下一代自主驾驶SOC(代号为“Xavier”)的加速技术。英伟达的举措意味着,如果ASIC在其他应用程序和其他客户中变得更加普及和引人注目,英伟达可以应对ASIC可能带来的任何竞争威胁。英伟达可以将技术生态系统扩展到公司的直接市场以外。

但是,双方的竞争是实实在在的,刀光剑影在也在暗中涌现。就在谷歌在乌镇峰会上大秀TPU的优越性能的当天。被誉为“坐上了火箭”的英伟达股价出现了罕见的下跌。随后,根据彭博社报道,5月25日软银集团公司悄悄收购了英伟达公司40亿美元(4.9%)的股份,成为该图形芯片制造商的第四大股东,英伟达股价开始恢复上涨。

国外媒体评论认为,TPU 推出后,应该感到忧虑的另一家公司是英特尔。在GPU的冲击下,英特尔已经十分落后,它没有跟上快速增长的 GPGPU (GPU上的通用计算)市场,这个市场上机器学习是重要的一块。

总体上看,会有更多机器学习应用转移到云端。在一些情况下,在云中租用 GPU 集群已经比在本地供应成本要低。英伟达 Volta GPU 和谷歌 Cloud TPU 的出现只会让这个差价越来越大。谷歌也清楚,增加在这个市场上的份额的关键是在自己的芯片上运行更多领先的软件,所以它抛出了TensorFlow Research Cloud 计划,为愿意分享自己工作成果的研究人员免费提供1000个Cloud TPU。

TPU 本身的局限明显,谷歌还会寻求合作

Cloud TPU 对机器学习行业的第一个战略意义在于,谷歌已经证明,ASIC 能够提供惊人的 ML 性能。谷歌正在将这项技术推广到外部以加速行业的发展。ML 行业对运算性能十分饥渴,而这款芯片不但非常快速,而且可扩展。即将推出的其他 ML ASIC (包括英特尔的 Nervana Engine,Wave Computing的数据流处理单元,英伟达 的 DLA 等等),也可看到 ASIC 的潜力。本质上,谷歌造的是一个非常出色的芯片,将所有逻辑都集中在神经网络的训练和处理底下的数学。通过一个定制的结构将数千个这样的芯片连接在一起,谷歌可以使用并提供超级计算机级别的性能,而成本只是在开放市场上购买系统的皮毛。

但是,造一个 ASIC 并不适合胆小者。首先,ASIC 功能有限。例如,谷歌TPU 只支持 TensorFlow,让使用 Microsoft,Amazon,Facebook 等的主流 AI 框架的用户只能选择在 GPU 上运行。(不过,谷歌还宣布将在 Google Cloud 上提供新的英伟达 V100 GPU。)此外,ASIC 的开发成本也很高。其复杂的设计可能要花费超过1亿美元,并且需要花费多年时间来设计和调试。(不过谷歌声称他们付出的努力要小得多。)

因此,像 TPU 这样的 ASIC,如果能够将这些成本分摊到大量使用中,起码是数十或数百万单位,才是有道理的。但谷歌需要这样大量的使用,因此收益可能很迅速而且戏剧化。要注意的是,由于开发 ASIC 可能需要花费很长的时间,在 AI 这个日新月异的市场中,芯片的设计可能会错过创新的机遇。这就是为什么包括百度、Amazon、Microsoft 等在内的许多数据中心都倾向于使用 GPU 或 英特尔和赛灵思的 FPGA 来加速关键工作负载,在提供高性能和高效率的同时随时能保持硬件升级的灵活性。一个厉害的团队可以几个月内就设计出一个新的 FPGA,不需要花费几年时间。

从战术上来说,这款芯片应该为谷歌显著地节省了成本,毕竟谷歌公司被广泛认为是世界上最大的机器学习芯片消费者。从战略上来说,它提供了一个专为公司以AI为中心的全球业务赋能的计算平台。谷歌的 Cloud TPU 具有深远的战略影响。

围棋大战背后的商业野心 ,向中国企业兜售TensorFlow+TPU+谷歌云

谷歌首席执行官 Sundar Pichar 已经明确表示,该公司的战略已经从“Mobile First”转变为“AI First”。Google Cloud TPU 的推出远比仅仅成为更便宜的GPU替代品更具战略意义。TPU 和 Google TensorFlow 框架为公司的工程师和数据科学家提供了一个全面优化的平台,以支持他们的研究和产品开发。 谷歌团队拥有产品上市时间、性能和功能优势,因为它们可以控制机器学习增强的产品和服务的硬件和软件。TPU 甚至可以提供未来的平台来支持公司的无人车愿景。

除了内部驱动程序之外,Google Cloud可以通过为TensorFlow开发项目提供卓越的价格/性能的硬件,从而在与Amazon Web Services和Microsoft Azure Cloud的竞争中受益。 当然,TensorFlow本身也可以受益。 它已经是许多机器学习应用程序团队使用的首选框架。TensorFlow Research Cloud旨在推动整个行业采用TensorFlow。

“在中国,BAT有大量的用户群,都想为用户提供更优化的服务,如果使用TensorFlow会变得更好,谁用TPU都会变得更好。”谷歌母公司Alphabet董事长施密特在乌镇峰会现场说。他还说,亚马逊和苹果都用过他们的产品,有很多有效的案例。

施密特的话一语道破了谷歌此次中国行的一大目的:兜售TensorFlow+TPU+谷歌云。

TensorFlow 经过两年多的发展,目前在Github上已经成为最受欢迎的深度学习框架,受到大量开发者的好评。另外,整合了机器学习技术的谷歌云,现在也已经蹿升为亚马逊和微软云的最大竞争对手之一。

最最关键的是,谷歌的深度学习框架、云和TPU等资源是互通和绑定的,这让它得以形成循环,逐渐笼络到更多的开发者。正如前文所说,谷歌已形成以AI战略为中心的完整平台,并且在将这个平台逐步推向企业、开发者和个人用户。在AI领域,谷歌正在打造真正的帝国。

根据新浪科技的报道,Jeff Dean 透露,中国 TensorFlow的用户数是7万。

消息显示,DeepMind CEO 哈萨比斯等人此番中国之行不仅在乌镇,还会与国内众多科技公司,包括BAT,进行接触和交流。由此看来,施密特先生要让BAT 试用TensorFlow和TPU的话并不是玩笑。

对于中国AI领域生态圈的巨头以及众多初创企业来说,这到底算是一颗氢弹还是一颗原子弹呢?

参考资料:https://www.forbes.com/sites/moorinsights/2017/05/22/google-cloud-tpu-strategic-implications-for-google-nvidia-and-the-machine-learning-industry/3/#5fae19b8513d